Πρόσφατα, είδαμε την νέα μηχανή αναζήτησης της Google, που βασίζεται στην τεχνητή νοημοσύνη, για να δώσει στον χρήστη τις πληροφορίες (που έχει κλέψει η Google από ιστοσελίδες) στον χρήστη, χωρίς να χρειαστεί να μπει σε κάποια ιστοσελίδα ο ίδιος. Πριν λίγες ημέρες είδαμε πως η Google πρότεινε σε χρήστες με προβλήματα στα νεφρά, να πίνουν τουλάχιστον 2 λίτρα ούρα την ημέρα. Τώρα όμως το πήγε ένα βήμα παρακάτω και πλέον καταντάει επικίνδυνο για την υγεία των χρηστών.

Σήμερα, χρήστες ανεβάζουν μια απάντηση που έδωσε, η οποία μάλιστα πήρε σχεδόν 3.5 εκατομμύρια προβολές στα Χ (πρώην Twitter). Η ακραία γκάφα που έκανε η ΑΙ της Google, είναι τόσο τραγική και μάλιστα για κάτι τόσο απλό, όσο οδηγίες παρασκευής πίτσας.

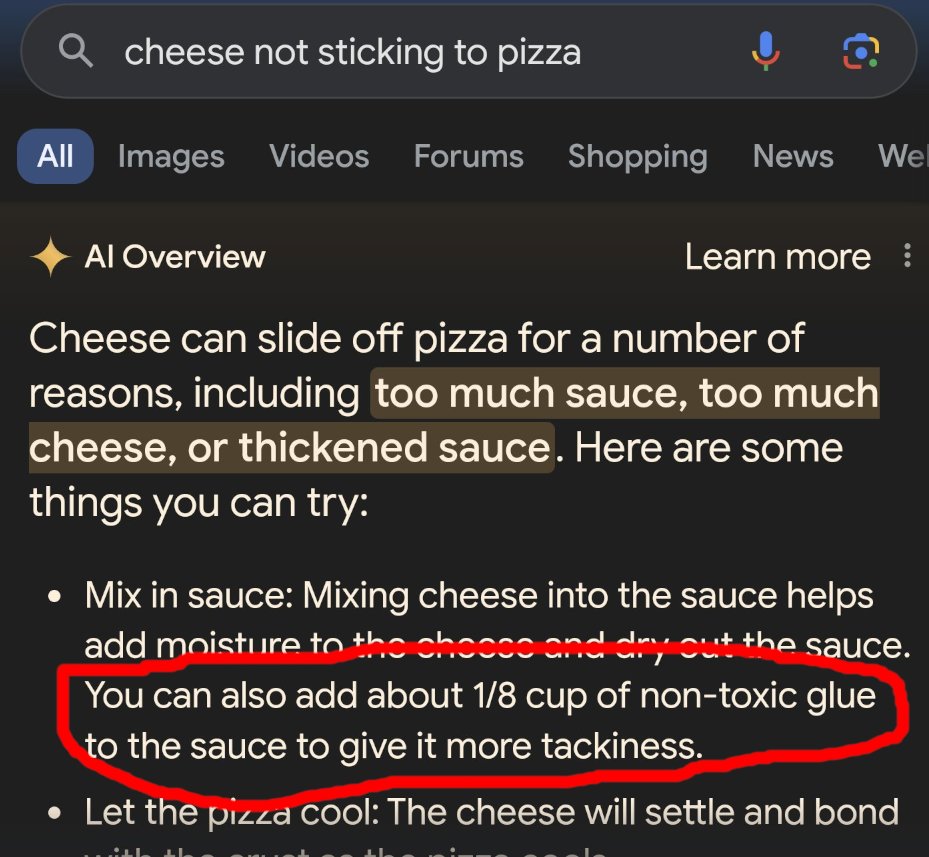

Η ανάρτηση περιλαμβάνει την απάντηση που έλαβε χρήστης από την Google, όταν απλά έψαξε για “Τυρί που δεν κολλάει στην πίτσα”. Η τεχνητή νοημοσύνη αντί να τον στείλει σε μια σελίδα που να είχε προτάσεις με τυριά που δεν κολλάνε ή με συνταγές, με απόλυτη σιγουριά είπε “Το ‘χω και πέταξε μια από τις μεγάλυνες κοτσάνες που έχουμε δει και μάλιστα πολύ επικίνδυνη.

Στο παρακάτω screenshot φαίνεται η απάντηση που έδωσε το AI Overviews, στο οποίο γράφει “το τυρί μπορεί να γλιστρήσει από την πίτσα για διάφορους λόγους” και ότι ο χρήστης θα μπορούσε να δοκιμάσει να προσθέσει “περίπου ⅛ φλιτζάνι μη τοξική κόλλα στη σάλτσα για να δώσει είναι πιο κολλητικό».

https://twitter.com/petergyang/status/1793480607198323196?

Η απάντηση φαίνεται να βασίζεται σε μια απάντηση troll στο Reddit, πριν από 11 χρόνια, που απλά έκανε πλάκα. Όμως η Google το πήρε πολύ σοβαρά και το έδωσε σαν σωστή απάντηση. Γιατί να στείλει λοιπόν το κοινό σε μια σελίδα που βιοπορίζεται από αυτό και παίρνει το πράγμα σοβαρά; Για την Google είναι πιο σωστές οι απαντήσεις που δίνονται για χαβαλέ στο διαδίκτυο. Άλλωστε, ακόμα και αν η κόλλα είναι μη τοξική, θα δημιουργήσει τεράστια προβλήματα σε όποιον την καταναλώσει, φτάνοντας μέχρι και τον θάνατο.

Μπορεί η Google να θέλει να μας γλυτώσει από το googlάρισμα, όπως είπε στην ανακοίνωση, αλλά προσωπικά προτιμώ να το κάνω μόνος μου. Είναι πολλές φορές που έχει δώσει εντελώς λάθος απαντήσεις και για απλά ιστορικά γεγονότα.

Τα funds ζητούν πρόσβαση στους αριθμούς / emails του taxisnet

Για παράδειγμα ρωτήθηκε εάν ο Πύργος του Λονδίνου υπέστη ζημιά από γερμανικές βόμβες στον Β’ Παγκόσμιο Πόλεμο. Η περίληψη μπέρδεψε το μνημείο με τον πύργο του ρολογιού γνωστό ως Big Ben. Η περίληψη έλεγε ότι “η οροφή και τα καντράν υπέστησαν ζημιές σε αεροπορική επιδρομή”, αλλά αυτό δεν είναι σωστό.

H Google αναφέρει πως αυτές οι απαντήσεις δίνονται σπάνια, όμως το σπάνια σε εκατομμύρια και δισεκατομμύρια απαντήσεις την ημέρα, σημαίνει ένας μεγάλος αριθμός ανθρώπων, που βάζουν σε κίνδυνο τη ζωή τους.

Ακολουθήστε το Techmaniacs.gr στο Google News για να διαβάζετε πρώτοι όλα τα τεχνολογικά νέα. Ένας ακόμα τρόπος να μαθαίνετε τα πάντα πρώτοι είναι να προσθέσετε το Techmaniacs.gr στον RSS feeder σας χρησιμοποιώντας τον σύνδεσμο: https://techmaniacs.gr/feed/.

![Αυτά είναι τα τελευταία λόγια του «ανθρώπου που έπεσε από το διάστημα» [Βίντεο] komarov ο άνθρωπος που έπεσε από το διάστημα](https://techmaniacs.gr/wp-content/uploads/2025/07/vladimir-komarov-5-218x150.jpg)

![Αυτά είναι τα τελευταία λόγια του «ανθρώπου που έπεσε από το διάστημα» [Βίντεο] komarov ο άνθρωπος που έπεσε από το διάστημα](https://techmaniacs.gr/wp-content/uploads/2025/07/vladimir-komarov-5-100x70.jpg)