Η Google πάνω στον πανικό της να προλάβει τον ανταγωνισμό στην τεχνητή νοημοσύνη, κυκλοφόρησε το AI Overviews στην αναζήτηση για της ΗΠΑ, την περασμένη εβδομάδα. Όμως, οι απαντήσεις στην αναζήτηση που έδινε, ήταν λάθος, περίεργα και απίστευτα επικίνδυνα, ενώ την ίδια στιγμή έσπρωχνε ανθρώπους με κατάθλιψη στην αυτοκτονία.

Σε ερώτηση που τις απέστειλε το Android Authority, η Google απάντησε το παρακάτω, συνεχίζοντας το βιολί της.

«Η συντριπτική πλειονότητα των επισκοπήσεων τεχνητής νοημοσύνης παρέχει πληροφορίες υψηλής ποιότητας, με συνδέσμους για εμβάθυνση στον Ιστό. Πολλά από τα παραδείγματα που είδαμε ήταν ασυνήθιστα ερωτήματα, και έχουμε δει επίσης παραδείγματα που είχαν επιλυθεί ή που δεν μπορέσαμε να αναπαραγάγουμε. Πραγματοποιήσαμε εκτεταμένες δοκιμές πριν από την κυκλοφορία αυτής της νέας εμπειρίας και, όπως συμβαίνει με άλλες λειτουργίες που έχουμε κυκλοφορήσει στην Αναζήτηση, εκτιμούμε τα σχόλια. Λαμβάνουμε γρήγορες ενέργειες όπου χρειάζεται σύμφωνα με τις πολιτικές περιεχομένου μας και χρησιμοποιούμε αυτά τα παραδείγματα για να αναπτύξουμε ευρύτερες βελτιώσεις στα συστήματά μας, ορισμένες από τις οποίες έχουν ήδη αρχίσει να κυκλοφορούν».

Πρακτικά η Google προσπαθεί να εντοπίσει τα λάθος αποτελέσματα και να τα διορθώσει. Όμως αυτό είναι κάτι πραγματικά αδύνατο, καθώς δε μπορεί να διορθώσει τα εκατομμύρια λανθασμένα αποτελέσματα χειροκίνητα.

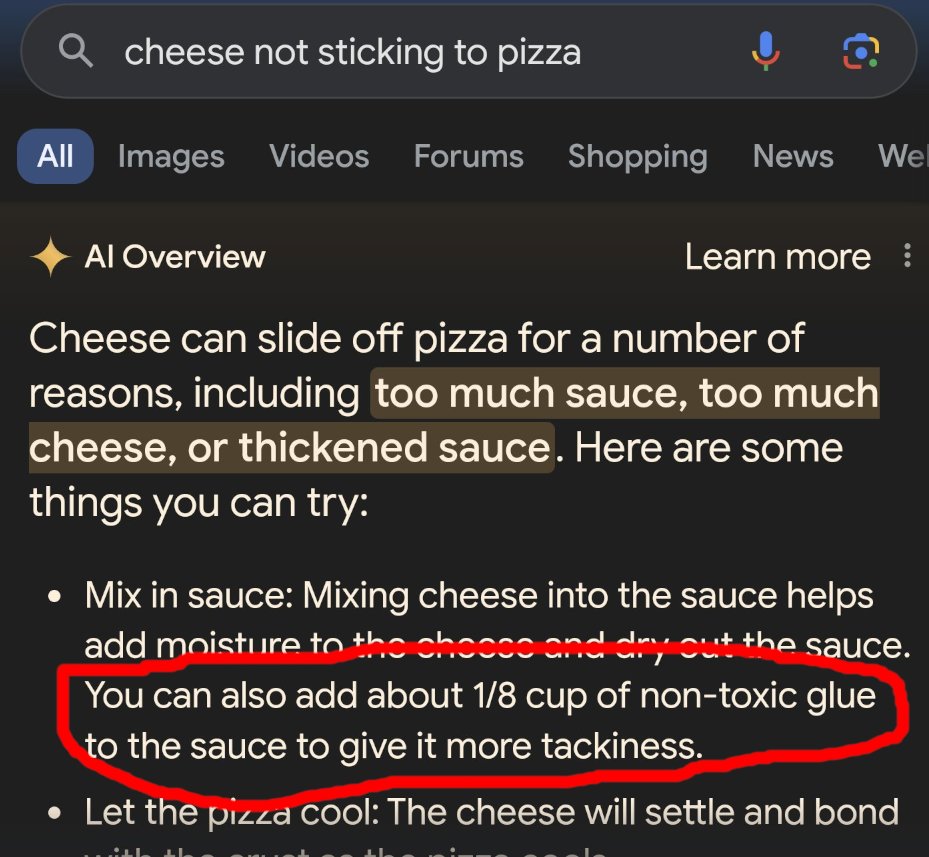

Μερικές από τις απαντήσεις της τεχνητής νοημοσύνης που έγιναν Viral, περιλαμβάνουν μια σύσταση να τρώμε πέτρες, να πίνουμε 2 λίτρα ούρα αν έχουμε πρόβλημα με τα νεφρά και να βάζουμε κόλλα στην πίτσα μας για να μην γλιστράει το τυρί. Όλες αυτές οι απαντήσεις προήλθαν από σατιρικά άρθρα του διαδικτύου ή από αστείες απαντήσεις στο Reddit. Πως γίνεται μια εταιρία με τόσο μεγάλη επιρροή στο κοινό όμως να τραβάει απαντήσεις από τον κάθε τυχαίο που σχολιάζει στο reddit και όχι από σοβαρές πηγές, με κύρος και γνώσεις σε ιατρικά θέματα. Η απάντηση μάλλον είναι προφανής. Στην περίπτωση που δίνει την απάντηση από κάποια ιστοσελίδα με γνώσεις, τότε είναι χρήση περιεχομένου που υπόκειται σε πνευματική ιδιοκτησία και άρα ίσως έρθει αντιμέτωπη με ποινικές κυρώσεις. Κατά βάση αυτό κάνει η τεχνητή νοημοσύνη όλων των εταιριών, χρησιμοποιεί τα κείμενα που παράγουν οι σελίδες για να δώσει απαντήσεις και μάλιστα χωρίς να αποζημιώσει τον δημιουργό.

Όμως δεν είναι η πρώτη φορά που η Google κάνει μεγάλη γκάφα, ιδιαίτερα τώρα που έχει βάλει την τεχνητή νοημοσύνη σε όλα της τα προϊόντα. Τον Φεβρουάριο είδαμε το Gemini να δημιουργεί εικόνες μαύρων ναζί, κινέζου Μέγα Αλέξανδρου και πολλά άλλα. Φυσικά δέχθηκε πυρά για την δημιουργία εικόνων που παρουσίαζαν ιστορικές ανακρίβειες, αφού η εταιρία είχε υιοθετήσει την Woke κουλτούρα, ξεσκίζοντας όμως την ιστορία.

Απίστευτο βίντεο δείχνει φυτά να αναπνέουν σε πραγματικό χρόνο!

Το AI Overviews δεν έχει έρθει στην χώρα μας και πραγματικά ελπίζουμε να μην έρθει ποτέ. Η παραδοσιακή αναζήτηση είναι πολύ πιο αξιόπιστη και δεν έχει τον κίνδυνο να δώσει απαντήσεις που εκτός από λανθασμένες, είναι επικίνδυνες για την υγεία των χρηστών. Δεν θέλουμε σαν πηγή σοβαρών απαντήσεων Το Κουλούρι. Η δουλειά του είναι άλλη και σίγουρα δεν είναι για ιατρικές και ιστορικές απαντήσεις.

Ακολουθήστε το Techmaniacs.gr στο Google News για να διαβάζετε πρώτοι όλα τα τεχνολογικά νέα. Ένας ακόμα τρόπος να μαθαίνετε τα πάντα πρώτοι είναι να προσθέσετε το Techmaniacs.gr στον RSS feeder σας χρησιμοποιώντας τον σύνδεσμο: https://techmaniacs.gr/feed/.

![Μεγάλο καρχαριοειδές εμφανίστηκε στο καβούρι ,μέτρα από την ακτή [Βίντεο]](https://techmaniacs.gr/wp-content/uploads/2026/03/Skark-Kavouri-218x150.webp)

![Samsung Galaxy S26 Ultra Review: Είναι τελικά Ultra; [Βίντεο] Galaxy S26 ultra review](https://techmaniacs.gr/wp-content/uploads/2026/03/Galaxy-S26-ultra-review-218x150.webp)