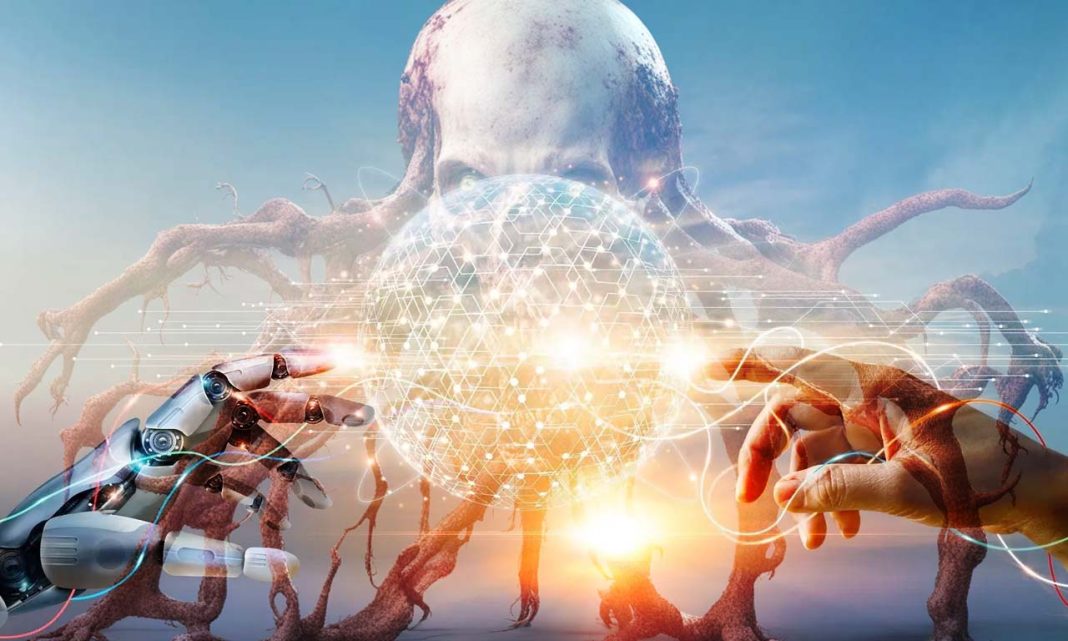

Τα μοντέλα γεννητικής τεχνητής νοημοσύνης (genetative AI ή Gen-AI ή GenAI), για να παράγουν τις «μαγικές» τους δημιουργίες, χρειάζονται τεράστιες ποσότητες δεδομένων από εικόνες, κείμενα και άλλες μορφές ανθρώπινης έκφρασης. Τι συμβαίνει όμως όταν στερέψουν από φρέσκα δεδομένα; Σαν ναυαγοί που δεν έχουν τροφή, αρχίζουν να «τρώνε» τον εαυτό τους, κάτι που μπορεί να έχει ανησυχητικές συνέπειες.

Μια νέα έρευνα από τα πανεπιστήμια Rice και Stanford στις ΗΠΑ δείχνει ότι όταν οι AI εκπαιδεύονται σε συνθετικά, μηχανικά δεδομένα αντί για αληθινά ανθρώπινα, η ποιότητα των παραγόμενων αποτελεσμάτων αρχίζει να υποφέρει. Οι ερευνητές ονομάζουν αυτό το φαινόμενο “Model Autophagy Disorder” (MAD). Οι AI ουσιαστικά «καταναλώνει» τον εαυτό του, όπως η σπογγοειδής εγκεφαλοπάθεια (mad cow disease) που εμφανίζεται σε αγελάδες που τρέφονται με μολυσμένα κατάλοιπα άλλων αγελάδων.

Χωρίς φρέσκα δεδομένα από τον πραγματικό κόσμο, το περιεχόμενο που παράγεται από τα μοντέλα γεννητικής τεχνητής νοημοσύνης χάνει την ποιότητά του και τη διαφορετικότητά του. Αυτό είναι ένα προειδοποιητικό σημάδι για το μέλλον της AI. Θεωρητικές και εμπειρικές αναλύσεις επέτρεψαν την πρόβλεψη του τι μπορεί να συμβεί όταν τα γεννητικά μοντέλα γίνουν πανταχού παρόντα και εκπαιδεύουν τα μελλοντικά μοντέλα σε αυτο-καταναλωτικούς βρόχους, σύμφωνα με τον Richard Baraniuk, μηχανικό υπολογιστών από το πανεπιστήμιο Rice.

Τρομάζουν οι ικανότητες δημιουργίας ρεαλιστικών εικόνων της Galaxy AI (δείγματα)

Η ομάδα των ερευνητών δούλεψε με ένα οπτικό γεννητικό μοντέλο AI, εκπαιδεύοντάς το σε τρεις διαφορετικούς τύπους δεδομένων: πλήρως συνθετικά, συνθετικά αναμεμιγμένα με αληθινά δεδομένα που ήταν σταθερά, και συνθετικά αναμεμιγμένα με αληθινά δεδομένα που ανανεώνονταν συνεχώς. Στα πρώτα δύο σενάρια, η ποιότητα των αποτελεσμάτων γινόταν όλο και χειρότερη, με εμφανή σφάλματα στις παραγόμενες εικόνες. Αντίστοιχα αποτελέσματα εμφανίζονται και στα LLMs, δηλαδή στα γλωσσικά μοντέλα παραγωγής κειμένου.

Χωρίς συνεχή ανανέωση με φρέσκα δεδομένα, το μέλλον των γεννητικών μοντέλων τεχνητής νοημοσύνης φαίνεται αβέβαιο και επικίνδυνο. “Ένα σενάριο καταστροφής είναι ότι, αν δεν ελεγχθεί για πολλές γενιές, το MAD θα μπορούσε να δηλητηριάσει την ποιότητα και την ποικιλία δεδομένων του διαδικτύου,” λέει ο Baraniuk. Το μέλλον της AI εξαρτάται από την ικανότητά μας να διατηρούμε τα δεδομένα φρέσκα και ποιοτικά.

Ακολουθήστε το Techmaniacs.gr στο Google News για να διαβάζετε πρώτοι όλα τα τεχνολογικά νέα. Ένας ακόμα τρόπος να μαθαίνετε τα πάντα πρώτοι είναι να προσθέσετε το Techmaniacs.gr στον RSS feeder σας χρησιμοποιώντας τον σύνδεσμο: https://techmaniacs.gr/feed/.

Νομίζω ότι είναι θέμα χρόνου η σύνδεση των μοντέλων με τον παγκόσμιο ιστό οπότε η άντληση νέων δεδομένων θα είναι απρόσκοπτη.