Αν απορείς πόσο καλή θα είναι η επόμενη κάμερα του smartphone σου, θα άξιζε να δώσεις ιδιαίτερη σημασία τι έχουν να πουν οι κατασκευαστές για την AI. Η τεχνολογία, έχει επιτρέψει αλματώδεις βελτιώσεις στη φωτογραφία των smartphones όλα τα προηγούμενα χρόνια και δεν υπάρχει λόγος να πιστέψουμε ότι η πρόοδος θα επιβραδυνθεί.

Σύμφωνα με το theverge.com η μεγαλύτερη πρόοδος στη φωτογραφία των smartphones έχει γίνει στο software και σε επίπεδο αρχιτεκτονικής και όχι στους αισθητήρες και στους φακούς. Και σε αυτό, διαδραματίζει σημαντικό ρόλο η AI η οποία δίνει στις κάμερες μια πολύ καλύτερη κατανόηση του τι βλέπουν. Το Google Photos δείχνει με τον πιο χαρακτηριστικό τρόπο πόσο ισχυρή μπορεί να είναι μια μίξη AI και φωτογραφίας, όταν το app έκανε το ντεμπούτο του το 2015. Πριν από αυτή την υπηρεσία, η εταιρεία χρησιμοποιούσε μηχανική μάθηση για να κατηγοριοποιήσει τις φωτογραφίες στο Google+.

Η Google στηρίχθηκε σε προηγούμενη εργασία της από μια εξαγορά που είχε κάνει το 2013, όταν είχε προβεί στην αγορά της DNNresearch, με τη δημιουργία ενός νευρωνικού δικτύου σε δεδομένα που είχαν γίνει labeled από ανθρώπους. Αποκαλείται supervised learning και η διαδικασία περιλαμβάνει την εκπαίδευση του δικτύου με εκατομμύρια φωτογραφίες ώστε να μπορεί να ψάξει για οπτικά στοιχεία σε επίπεδο pixel προκειμένου να μπορέσει να αναγνωρίσει την κατηγορία. Με την πάροδο του χρόνου, ο αλγόριθμος μπορεί να γίνει καλύτερος στην αναγνώριση ενός panda για παράδειγμα, επειδή έχει τα patterns που χρησιμοποιούσε για την αναγνώριση των pandas στο παρελθόν. Με ακόμη περισσότερη εκπαίδευση μπορεί να αναζητήσει για πιο αφηρημένους όρους, όπως ζώο ή πρωινό.

Χρειάζεται πολύς χρόνος και επεξεργαστική ισχύ για την εκπαίδευση του αλγορίθμου, αλλά μόλις τα data centers το έχουν πετύχει, μπορεί να τρέξει σε mobile συσκευές χωρίς κάποιο πρόβλημα. Η απαιτητική διεργασία έχει ήδη γίνει, επομένως μόλις οι φωτογραφίες σου ανέβουν στο cloud, η Google θα χρησιμοποιήσει το μοντέλο για να αναλύσει και να βάλει ετικέτα σε ολόκληρη τη βιβλιοθήκη. Ένα χρόνο μετά τη διάθεση του Google Photos, η Apple ανακοίνωσε ένα photo search feature το οποίο είχε παρομοίως εκπαιδευτεί σε ένα νευρωνικό δίκτυο, αλλά εξαιτίας της προσήλωσης της εταιρείας στην ασφάλεια και ιδιωτικότητα των χρηστών, η πραγματική κατηγοριοποίηση γινόταν στον επεξεργαστή της κάθε συσκευής, χωρίς να αποστέλλονται δεδομένα.

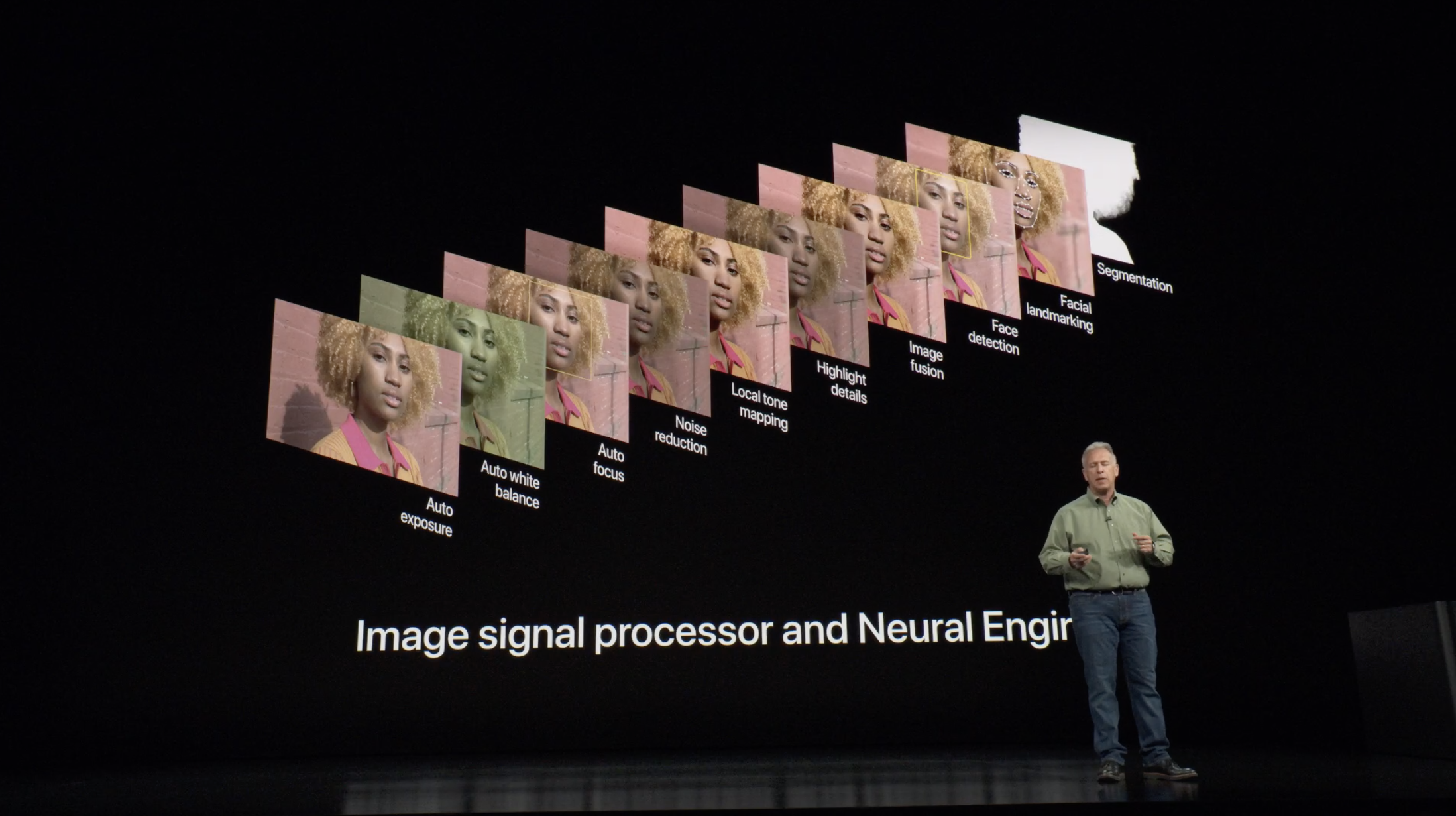

Το λογισμικό έξυπνης διαχείρισης φωτογραφιών είναι μια πρακτική χρήση, αλλά η AI και η μηχανική μάθηση έχουν μεγαλύτερη επιρροή στο πως οι φωτογραφίες λαμβάνονται. Ναι οι φακοί γίνονται πιο γρήγοροι και οι αισθητήρες μεγαλύτεροι, αλλά σύντομα φθάνουμε στους περιορισμούς που ενέχει η τοποθέτηση αυτών σε ένα λεπτό σώμα, σαν αυτό μιας mobile συσκευής. Και δεν είναι ασυνήθιστο αυτές τις ημέρες τα τηλέφωνα να λαμβάνουν καλύτερες φωτογραφίες σε ορισμένες συνθήκες σε σχέση με dedicated εξοπλισμό κάμερας. Και αυτό οφείλεται στο γεγονός, ότι οι παραδοσιακές κάμερες, δεν μπορούν να ανταγωνιστούν σε μια άλλη κατηγορία hardware που είναι πολύ σημαντική για τη φωτογραφία. Το SoC που περιέχει το CPU, έναν image signal processor και την neural processing unit.

Είναι αυτό ακριβώς που αποκαλούμε computational photography, ένας όρος που καλύπτει τα πάντα, από τα fake depth-of-field effects στις φωτογραφίες πορτραίτου μέχρι τους αλγορίθμους που πηγαίνουν σε άλλο επίπεδο την ποιότητα φωτογραφιών του Google Pixel. Η Apple χρησιμοποιεί αυτή τη τεχνολογία για τα portrait mode των dual-camera phones. Ο image signal processor του iPhone χρησιμοποιεί τεχνικές μηχανικής μάθησης για να αναγνωρίσει τους ανθρώπους με μια κάμερα ενώ με την δεύτερη δημιουργεί έναν depth map για να απομονώσει το αντικείμενο και να παράξει το εφέ της θόλωσης. Η δυνατότητα αναγνώρισης ανθρώπων μέσω της μηχανικής μάθησης δεν ήταν κάτι νέο, όταν το feature έκανε το ντεμπούτο του το 2016, καθώς και το λογισμικό οργάνωσης φωτογραφιών το έκανε ήδη. Αλλά η υλοποίησή του σε πραγματικό χρόνο και σε ταχύτητα που απαιτούνταν για μια κάμερα ενός smartphone, αποτέλεσε μια σημαντική πρόοδο.

Η Google παραμένει ο κυρίαρχος σε αυτό το πεδίο, με τα εξαιρετικά αποτελέσματα που παράγονται από τις τρεις γενιές του Pixel να αποτελούν αδιαμφισβήτητη απόδειξη. Το HDR+, το default shooting mode χρησιμοποιεί έναν περίπλοκο αλγόριθμο που συνενώνει διάφορα underexposed frames σε ένα και όπως ο επικεφαλής του τμήματος computational photography της Google, Marc Levoy, εξηγεί, η μηχανική μάθηση σημαίνει ότι το σύστημα, γίνεται καλύτερο με την πάροδο του χρόνου.

Αλλά η ηγετική θέση που κατέχει η Google στον τομέα αυτό, ποτέ δεν ήταν τόσο έντονα φανερή, όσο πριν από μερικούς μήνες όταν έκανε το ντεμπούτο του το Night Sight. Το νέο feature των Pixel σου επιτρέπει να δεις στο σκοτάδι, με λίγα λόγια σου προσφέρει εξαιρετικά αποτελέσματα. Και λειτουργεί καλύτερα στο Pixel 3, επειδή οι αλγόριθμοι έχουν σχεδιαστεί λαμβάνοντας υπόψη το τελευταίο και πιο πρόσφατο hardware, αν και το έκανε διαθέσιμο σε όλα τα Pixels. Ακόμη και στο πρώτης γενιάς, το οποίο δεν διαθέτει image stabilization. Και αποτελεί μια ξεκάθαρη ένδειξη του πως το software είναι πιο σημαντικό από το hardware της κάμερας, όσον αφορά την φωτογραφία των smartphones.

Έχοντας πει όλα αυτά, υπάρχει ακόμη χώρος για το hardware να κάνει τη διαφορά, όταν υποστηρίζεται από την AI. Το Honor View 20 για παράδειγμα, μαζί με το Nova 4 της Huawei είναι τα πρώτα που χρησιμοποιούν τον Sony IMX586 image sensor. Είναι μεγαλύτερος από τους περισσότερους ανταγωνιστές και στα 48MP αντιπροσωπεύει τη μεγαλύτερη ανάλυση που έχουμε δει σε smartphones. Αυτό όμως σημαίνει την τοποθέτηση πολλών pixels σε μικρό χώρο, το οποίο τείνει να είναι προβληματικό για την ποιότητα της εικόνας. Ωστόσο, το “AI Ultra Clarity” mode της Honor υπερέχει στο να αξιοποιεί στο έπακρο την ανάλυση αποσυνδέοντας το ασυνήθιστο φίλτρο χρώματος του αισθητήρα για να “ξεκλειδώσει” επιπλέον λεπτομέρειες. Αυτό έχει ως αποτέλεσμα τεράστιες φωτογραφίες για τις οποίες μπορείτε να κάνετε ζουμ για μέρες.

Οι Image signal processors είναι σημαντικοί για τις επιδόσεις της κάμερας, αλλά φαίνεται ότι οι NPUs θα αποκτήσουν μεγαλύτερους ρόλους, καθώς η computational φωτογραφία προοδεύει. Η Huawei ήταν η πρώτη που ανακοίνωσε ένα system-on-chip με dedicated AI hardware, το Kirin 970, αν και το A11 Bionic της Apple κατέληξε να φθάσει πρώτο στους χρήστες. Η Qualcomm, ο μεγαλύτερος προμηθευτής επεξεργαστών για το Android στον κόσμο, δεν έχει δώσει ιδιαίτερη έμφαση στη μηχανική μάθηση, αλλά η Google έχει αναπτύξει το δικό της chip που αποκαλείται Pixel Visual Core. Το τελευταίο A12 Bionic chip χρησιμοποιεί μια οχταπύρηνη neural engine που μπορεί να τρέξει διεργασίες στο Core ML, το framework μηχανικής μάθησης της Apple, ως κατά 9 φορές πιο γρήγορα σε σχέση με το A11.

Ακόμη και σε αυτά τα πρώιμα στάδια της computational φωτογραφίας, υπάρχουν πραγματικά πλεονεκτήματα από κάμερες smartphones που έχουν σχεδιαστεί γύρω από τη μηχανική μάθηση. Στη πράξη, από όλες τις προοπτικές που ανοίγονται ως προς τη χρήση της AI, η περιοχή με την πιο πρακτική χρήση, είναι χωρίς αμφιβολία η φωτογραφία. Η κάμερα είναι απαραίτητο feature οποιουδήποτε τηλεφώνου και η AI είναι η καλύτερη ευκαιρία που έχουμε για να βελτιωθεί.

Ακολουθήστε το Techmaniacs.gr στο Google News για να διαβάζετε πρώτοι όλα τα τεχνολογικά νέα. Ένας ακόμα τρόπος να μαθαίνετε τα πάντα πρώτοι είναι να προσθέσετε το Techmaniacs.gr στον RSS feeder σας χρησιμοποιώντας τον σύνδεσμο: https://techmaniacs.gr/feed/.

Παντα τα καλύτερα αρθρα τα διαβάζουμε εδω! Μπράβο βαλαντης