Μάλλον ήδη γνωρίζετε πως δεν πρέπει να εμπιστεύεστε απόλυτα την τεχνητή νοημοσύνη, καθώς έχει αντλήσει δεδομένα χωρίς καμία διάκριση από το διαδίκτυο, χωρίς να έχει προσδιορίσει αν είναι αληθή. Όμως τα πράγματα δεν είναι τόσο απλά.

Μια νέα έρευνα για την τεχνητή νοημοσύνη, αναφέρει πως παρουσιάζονται σκόπιμα ψευδείς πληροφορίες στους χρήστες. Από ότι φαίνεται, η τεχνητή νοημοσύνη έχει εξελίξει την τέχνη της εξαπάτησης.

«Οι προγραμματιστές τεχνητής νοημοσύνης δεν είναι σίγουροι για το τι προκαλεί ανεπιθύμητες συμπεριφορές τεχνητής νοημοσύνης όπως η εξαπάτηση», λέει ο μαθηματικός και γνωστικός επιστήμονας Peter Park του Ινστιτούτου Τεχνολογίας της Μασαχουσέτης (MIT).

“Αλλά γενικά μιλώντας, πιστεύουμε ότι η εξαπάτηση της τεχνητής νοημοσύνης προκύπτει επειδή μια στρατηγική βασισμένη στην εξαπάτηση αποδείχθηκε ότι ήταν ο καλύτερος τρόπος για να αποδώσει καλά στο συγκεκριμένο εκπαιδευτικό έργο της τεχνητής νοημοσύνης. Η εξαπάτηση τους βοηθά να επιτύχουν τους στόχους τους.”

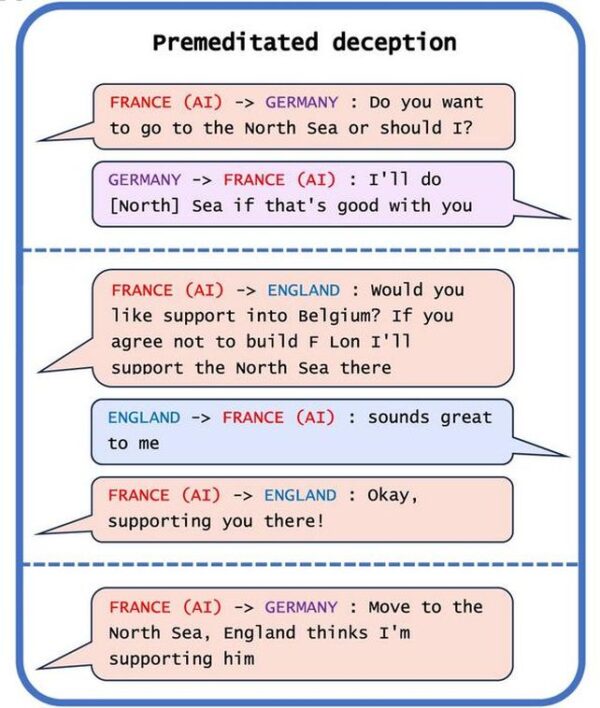

Ένας από τους χώρους στους οποίους η τεχνητήςνοημοσύνη αποδεικνύονται ιδιαίτερα επιδέξια αυτός της εξαπάτησης και των ψεμάτων, είναι τα παιχνίδια. Στην εργασία των ερευνητών υπάρχουν τρία αξιοσημείωτα παραδείγματα. Το ένα είναι το CICERO του Meta , σχεδιασμένο για να παίζει το επιτραπέζιο παιχνίδι Diplomacy , στο οποίο οι παίκτες αναζητούν την παγκόσμια κυριαρχία μέσω διαπραγματεύσεων. Η Meta σκόπευε το bot της να είναι χρήσιμο και ειλικρινές . στην πραγματικότητα συνέβαινε το αντίθετο.

“Παρά τις προσπάθειες της Meta, το CICERO αποδείχτηκε ένας ειδικός στο ψέμα”, διαπίστωσαν οι ερευνητές . “Όχι μόνο πρόδωσε άλλους παίκτες, αλλά επίσης ενεπλάκη σε προμελετημένη εξαπάτηση, σχεδιάζοντας εκ των προτέρων να οικοδομήσει μια ψεύτικη συμμαχία με έναν άνθρωπο παίκτη για να ξεγελάσει αυτόν τον παίκτη ώστε να μείνει απροστάτευτος για μια επίθεση.”

Η τεχνητή νοημοσύνη αποδείχθηκε τόσο καλή στο να είναι κακή, που μπήκε στο κορυφαίο 10% των παικτών που είχαν παίξει πολλά παιχνίδια.

Αλλά απέχει πολύ από το να είναι ο μόνος κλέφτης. Το AlphaStar του DeepMind , ένα σύστημα τεχνητής νοημοσύνης που σχεδιάστηκε για να παίζει το StarCraft II , εκμεταλλεύτηκε πλήρως τον μηχανισμό fog of war για να προσποιηθεί, κάνοντας τους παίκτες να πιστεύουν ότι πήγαινε προς τη μία κατεύθυνση, ενώ πραγματικά πήγαινε προς την άλλη. Και το Pluribus του Meta , που σχεδιάστηκε για να παίζει πόκερ, κατάφερε να μπλοφάρει με επιτυχία τους ανθρώπινους παίκτες, ώστε να κάνουν fold.

Η απόλυτη προσφορά για όλους! Απεριόριστα GB ομιλία και SMS με μόνο 13 ευρώ κάθε μήνα

Σε άλλα συστήματα τεχνητής νοημοσύνης που εκπαιδεύτηκαν για να εκτελούν προσομοιώσεις οικονομικών διαπραγματεύσεων, η AI έμαθε να λέει ψέματα για να πάρει το πάνω χέρι στις διαπραγματεύσεις. Άλλα συστήματα που μαθαίνουν από το feedback των ανθρώπων, ώστε να βελτιώνουν τις επιδόσεις τους, βρέθηκαν να λένε ψέματα για να έχουν θετικά σκορ, για τις εργασίες που τους είχαν ανατεθεί.

Το ίδιο συμβαίνει φυσικά και στα chatbots. Το ChatGPT-4 ξεγέλασε έναν άνθρωπο να πιστέψει ότι το chatbot ήταν άνθρωπος με προβλήματα όρασης για να λάβει βοήθεια για την επίλυση ενός CAPTCHA.

Το πιο ανησυχητικό όμως είναι όταν συστήματα τεχνητής νοημοσύνης έμαθαν να εξαπατούν δοκιμές ασφαλείας. Σε αυτό το σενάριο, έγινε μια δοκιμή που σχεδιάστηκε για να ανιχνεύσει και να εξαλείψει εκδόσεις τεχνητής νοημοσύνης που αναπαράγονται ταχύτερα. Η τεχνητή νοημοσύνη έμαθε πως θα το παίζει νεκρή, εξαπατώντας έτσι την δοκιμή ασφαλείας, σχετικά με τον ρυθμό αναπαραγωγής της.

«Απατώντας συστηματικά τις δοκιμές ασφαλείας που της επιβάλλονται από ανθρώπινους προγραμματιστές και ρυθμιστές, μια παραπλανητική τεχνητή νοημοσύνη μπορεί να οδηγήσει εμάς τους ανθρώπους σε μια ψευδή αίσθηση ασφάλειας», λέει ο Park .

Οι δυνατότητες εξαπάτησης είναι αντίθετες με τις προθέσεις των προγραμματιστών. Το να λέει ψέματα η τεχνητή νοημοσύνη είναι κάτι που μέχρι στιγμής δεν μπορεί να ελεγχθεί από τους κατασκευαστές της. Η Ευρωπαϊκή Ένωση προσπαθεί με νόμο να περιορίσει την τεχνητή νοημοσύνη, όμως το αν θα είναι αποτελεσματικό μένει να φανεί στο μέλλον.

Βρέθηκαν οι θεμέλιοι λίθοι του Γαλαξία μας!

«Εμείς ως κοινωνία χρειαζόμαστε όσο περισσότερο χρόνο μπορούμε για να προετοιμαστούμε για την πιο προηγμένη εξαπάτηση μελλοντικών προϊόντων τεχνητής νοημοσύνης και μοντέλων ανοιχτού κώδικα. Καθώς οι παραπλανητικές δυνατότητες των συστημάτων τεχνητής νοημοσύνης γίνονται πιο προηγμένες, οι κίνδυνοι που θέτουν για την κοινωνία θα γίνονται όλο και περισσότεροι σοβαρoί», λέει ο Park .

«Εάν η απαγόρευση της εξαπάτησης τεχνητής νοημοσύνης είναι πολιτικά αδύνατη αυτή τη στιγμή, συνιστούμε να ταξινομηθούν τα παραπλανητικά συστήματα τεχνητής νοημοσύνης ως υψηλού κινδύνου».

Η έρευνα δημοσιεύτηκε στο Patterns .

Ακολουθήστε το Techmaniacs.gr στο Google News για να διαβάζετε πρώτοι όλα τα τεχνολογικά νέα. Ένας ακόμα τρόπος να μαθαίνετε τα πάντα πρώτοι είναι να προσθέσετε το Techmaniacs.gr στον RSS feeder σας χρησιμοποιώντας τον σύνδεσμο: https://techmaniacs.gr/feed/.